[정보]충공깽 이미지 수정! DragGAN 데모 간단 사용법~ 리뷰~

전에 소개한 링크로 들어가면 데모를 실행할 수 있는 방법이 쭉 나옵니다. 물론 제일 쉬운 건 허깅페이스와 오픈x랩스에 제공되는 웹UI를 이용하는 겁니다. 원클릭으로 가능. 아래 주소로 가보세요.

Apps-OpenXLab

openxlab.org.cn

가보시면 아시겠지만, 이게 쓰는 사람이 많으면 줄을 서야 합니다. ㅋㅋㅋ 그래서 한 번 돌리고 내 차례 올 때까지 기다려야 함.

위와 같은 사유로 저는 제 컴퓨터, 로컬에 설치해서 돌렸는데(요거도 튜토 올리겠슴다) 아오 진짜 느려터져가지고 ㅋㅋㅋㅋ 스테이블 디퓨전으로 이미지 뽑는 거랑은 또 다르게 엄청 자원 잡아먹네요. 아무튼 결과 이미지부터 보시겠습니다.

원본 이미지

DragGan으로 입벌림 ㅋㅋㅋㅋ

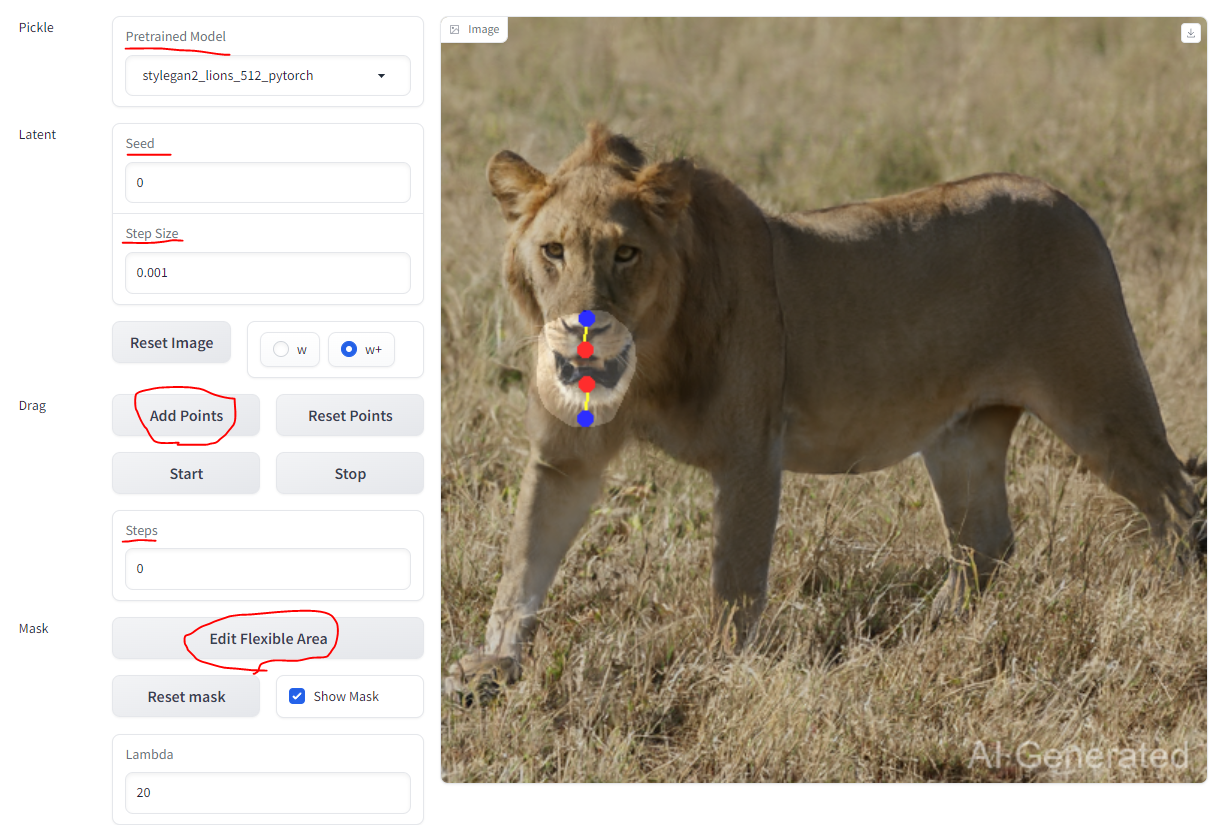

오늘은 뭐 다른 거 제끼고 대충 사용법만 알아봅시다. 매우----- 간단합니다. 위 사이트나 로컬 설치하면 이런 UI가 보일겁니다.

pre-trained 모델에서 사람이나 개, 사자, 고양이 이런 거 골라서 수정해볼 수 있습니다. 즉 원하는 범주의 이미지를 수정하게 위해선 따로 훈련이 필요하다는 거죠. 한계점이긴 한데 이제 시작이니까 나중엔 아무거나 막 보정할 수 있겠죠? ㅋㅋ

seed 는 아시죠? 저거 숫자 변경하면 사자의 모습이 막 바뀝니다.

step-size 일종의 학습률인데 이거 올라가면 수정폭이 커져서 확확 바뀝니다. 빨라지죠. 단 퀄리티는 하락합니다. 확 올려보세요. 난장판됩니다. 0.001~0.003 정도 추천합니다.(로컬환경 (rtx3060 12g에선 0.002도 버겁더라고요-_-;;)

reset image 는 뭐 이미지 리셋이고요.

w랑 w+는 논문에 보면 잠재영역에 대한 설정이야긴데 w로 하면 좀 더 제약이 있고, w+는 좀 더 자유도가 높습니다. 결정론 vs 랜덤 정도 아닐까 싶네요. 해보니까 작은 변화에서 큰 차이는 모르겠습니다.

자 이제부터 중요한 거 ㅋㅋ

add point 누르고 클릭하면 빨간 점 찍히고 다시 찍으면 파란 점 찍히죠? 시작 포인트와 엔드 포인트입니다. 위에 저처럼 설정하면 사자가 입을 벌리겠죠? 점은 여러 개 찍을 수 있습니다. 속도는 엄청 느려지죠. ㅋㅋ

start버튼 누르면 바로 보정 및 수정이 시작됩니다. stop누르면 멈추고요, steps는 연산 횟수를 카운트합니다. 횟수가 올라가면서 사자가 입 벌립니다. ㅋㅋㅋ

밑에 edit flexible mask는 말 그대로 마스크 지정이죠. 사자 주둥이만 벌리고 싶은 건데 마스킹 안 하면 전체 이미지에 골고루 영향을 줘버리니까 저는 저렇게 주둥이에 빙 둘러놨습니다.

마지막 lambda는 (알아본 결과 ㅋㅋ) 길게 설명하긴 좀 복잡하던데, 아무튼 값이 낮아질수록 랜덤하지 않고 결정론적이 되고, 높아질수록 랜덤해집니다. 그니까 사자 입을 벌려야 하는데 너무 낮으면 뭐랄까 정답만 따라가려고 하니까 스무스하지 않게 벌어질 것이고 너무 높으면 또 정답에서 멀어지니까 요상해지겠죠? 중간값을 찾는 게 중요한데 해보니까 큰 영향이 없는 것 같아서 걍 기본값 뒀습니다.;;;; 지적 및 보충 부탁드립니다~

암튼 꽤 재미있고, 이거 https://github.com/NVlabs/stylegan3 여기가면 모델학습도 가능할 거 같던데(확실치는 않음) 테스트 해볼만 한 거 같습니다.

사자 이거저거 수정해본 거 첨부합니다. 비슷비슷하네요 ㅋㅋㅋ 이만~ㅋㅋ