네. OpenAI의 chatGPT가 물론 지금으로서 선택할 수 있는 최고의 옵션인 건 맞습니다. 특히 한글 사용자라면 더욱 그렇죠. 하지만 월 20달러의 비용은 마냥 싸다고만 볼 수는 없죠. 무엇보다 지천에 오픈소스로 LLM모델이 널려있는 요즘 같은 때에 말입니다. 딱히 검열도 안 하는 uncensored 모델(욕하면 같이 욕박음 ㅎㄷㄷ)도 많고요.

근데 문제는 저런 모델 돌리려면 파이썬도 좀 다룰 줄 알고 판다스니 넘파이니 트랜스포머니 뭐니 AI개발에 대해서도 알아야 합니다. chatGPT같은 UI는 언감생심 꿈도 못꾸고, 암울한 터미널 창에 뜨는 코드형식 답변받아야 합니다. ㅋㅋㅋㅋ우리 같은 비개발자들 친화적이 아니죠. 그렇다고 구경만 할 거냐?

아니죠. 스테이블 디퓨전처럼 오픈소스 LLM(거대언어모델)을 로컬에 다운로드 받아서 직접 챗봇을 돌리고 파인튜닝도 가능한 web UI가 있습니다. 가보시면 개발 목적 자체가 텍스트 생성계의 스테이블 디퓨전이라고 명시돼있습니다. ㅋㅋ당연히 다 무료로 사용가능하고요. 심지어 더 쉽습니다. ㅋㅋ

바로 oobabooga가 그런 겁니다.

설치 자체는 다 자동이고 너무 쉽기 때문에 사실 딱히 뭐 튜토리얼할 만한 것도 없긴 합니다만... 그래도 앞으로 좀 이거저거 해보려고 올려봅니다.ㅋㅋㅋ

일단 아래 주소로 고고싱.

https://github.com/oobabooga/text-generation-webui

가보심 사용OS에 맞춰서 원클릭 설치 압축파일 다운로드 받을 수 있습니다. 수동설치도 물론 가능합니다. 아래로 내려서 설명보심 나와요. 그런데 뭐 굳이..ㅋㅋㅎㅎ

GitHub - oobabooga/text-generation-webui: A gradio web UI for running Large Language Models like LLaMA, llama.cpp, GPT-J, Pythia

A gradio web UI for running Large Language Models like LLaMA, llama.cpp, GPT-J, Pythia, OPT, and GALACTICA. - GitHub - oobabooga/text-generation-webui: A gradio web UI for running Large Language Mo...

github.com

보시다시피 윈도우는 AMD 안 되고요. 역시 AI는 Nvidia...Cuda...

다운 받아서 원하는 폴더에 압축푸시면 파일 나오죠? 설명Instruction 열어서 읽어보세요.

start_windows 더블클릭하면 알아서 실행됩니다.

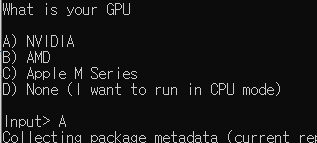

그다음 그래픽 카드 선택해주시고요.

전 윈도우니까 당연히 Nvidia... CPU로만도 돌릴 수 있는 것처럼 보이긴 하는데 헬이 예상되기 때문에 집에서 이미지든 채팅이든 돌리려면 최하 RTX3060이상 추천드립니다... 이것도 버거움-_-

그럼 뭐 지가 알아서 죽 다 설치합니다. 필요한 거. 꽤 걸립니다..

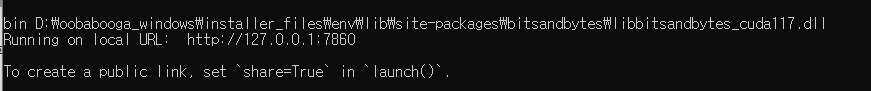

설치가 끝나면 우리에게 익숙한 장면이 딱 나오죠.

네. 로컬URL ㅋㅋㅋ 스테이블 디퓨전이랑 똑같죠?ㅋㅋ 접속하면 짜라라란!

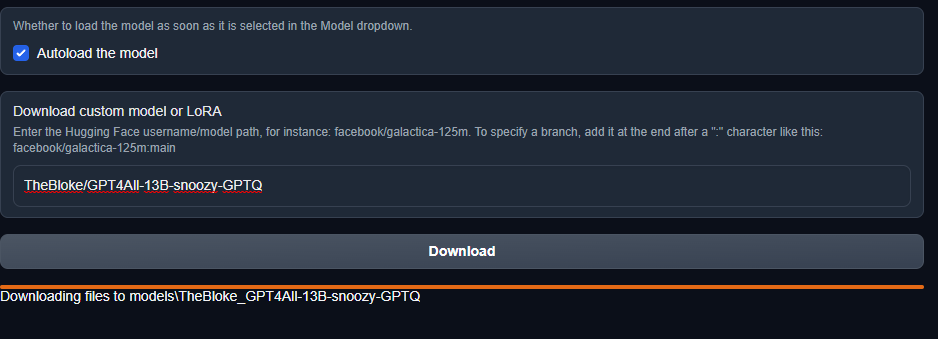

네 너무 익숙하고 깰끔한 gradio UI가 뜨죠. ㅋㅋ 이제 모델 다운받고 써보면 됩니다. 요건 여기서 끝낼라다 그래도 명색이 튜토리얼 붙였으니까 모델 다운로드까지만 가보죠. 위쪽에 모델Model 탭을 선택해줍니다.

Download custom model or LoRA 가 있죠? 설명보면 허깅페이스 username/mode path 넣으라고 돼있죠? 예를들어 저는 아래 주소의 모델을 쓰고 싶습니다. (여기도 LoRA가 나오죠? 이미지 생성에만 적용되는 기술이 아닙니다. ㅎㅎ LoRA부터 할 걸 그랬네요.ㅎㅎ)

TheBloke/GPT4All-13B-snoozy-GPTQ · Hugging Face

# GPT4All-13B-snoozy-GPTQ This repo contains 4bit GPTQ format quantised models of Nomic.AI's GPT4all-13B-snoozy. It is the result of quantising to 4bit using GPTQ-for-LLaMa. Repositories available How to easily download and use this model in text-generatio

huggingface.co

딱 보이죠? 가보시면 username/mode path 복사하게 딱 만들어놨습니다. 이렇게요.

GPT4ALL 13B 130억개의 파라미터를 가지고 훈련한 거죠. 파라미터는 가중치, 편향 한마디로 교육자료 정도로 보면 됩니다.

복사 버튼 눌러서 복사 그 다음 Download custom model or LoRA에 붙여넣기.

요렇게 지가 알아서 다운받습니다.

여기서 진심 개꿀팁 하나 드리자면 이게 세월아네월아 뭐 진전이 안 되는 것처럼 보이시는 분. 네. 실제로 그렇습니다. ㅋㅋㅋㅋcmd 터미널창을 보세요. 아마 아무것도 진행이 안 되고 있을지도 모릅니다. 이렇게 다운로드가 되고 있어야 합니다.

아닌 경우 터미널 창으로 가서 가볍게 엔터 한 번 쳐보세요. ㅋㅋㅋ 그럼 됩니다. ㅋㅋ제가 그랬음 ㅋㅋ이거는 다른 경우에도 마찬가지인데 가끔 다른 것도 터미널에서 설치할 때나 이런 저런 경우 멈출 때 있으니까 그럴 땐~가볍게 엔터~

다운받은 후에 모델이 로드되지 않는 경우가 있을 겁니다. 모델 아래 쪽에 있는 모델로더 설정이 잘못됐거나 맞지 않으면 모델이 로드되지 않습니다. 모델 로더는 말 그대로 모델을 웹서비스로 가져오고 최적화하는 그런 겁니다. 모델 로더에 따라서도 모델 성능이 달라지니 참고하세요. 위 모델의 경우 아래처럼 ExLlama 선택 시 바로 로드가 됩니다. ExLlma 모델로더가 VRAM도 덜 잡아먹고 여러 면에서 상당히 괜찮습니다.

혹은 잘 안 된다 싶으면 다른 모델을 다운받아서 시도해보시기 바랍니다. 좀 더 작은 모델로~

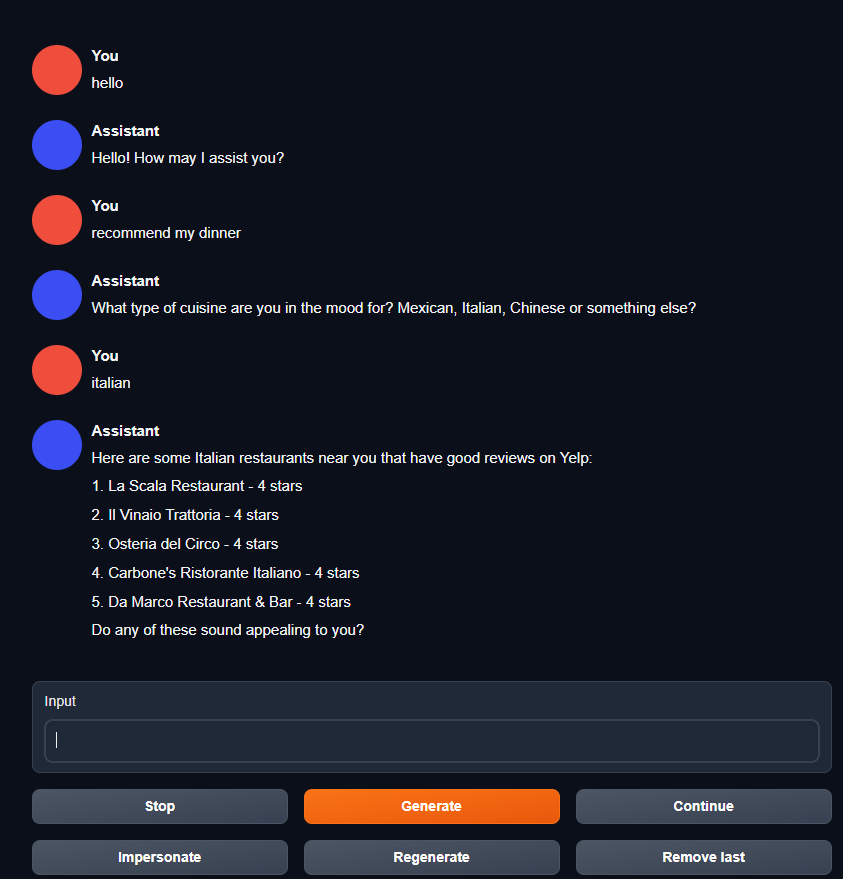

자 이제 그냥 바로 테스트 해봅시다. 저는 모드를 채팅으로 바꿨습니다. 아래처럼 세션 탭에서 바꿀 수 있습니다.

자자자! 그만하고 테스트 해보죠!

잘 됩니다.

문제?랄지 단점이 하나 있다면, 한글로 사용하기에는 아직 부족하다는 거죠. 구글 번역을 extension으로 사용가능하지만! 많이 불편한 게 사실입니다. 뭐 점점 더 양질의 모델이 늘어나겠죠. 이미 koalpaca 등등 있지만 chatGPT만 못하고 뤼튼만 못한 걸로 알고 있습니다. 암튼 한글모델도 찾아서 계속 테스트해보기로 합시다~ 그럼~

출처 - 아직도 돈 내고 chatGPT 쓰시나요? TEXT생성계의 스테이블 디퓨전! <oobabooga 깨부수기 -1-> : 네이버 카페 (naver.com)

AI ARTWORK LAB : 네이버 카페

stable diffusion 기반 이미지 생성을 비롯한 자연어처리 인공지능을 연구합니다. 쉽고~ 재미있게~

cafe.naver.com

'ai 만들어보기(feat ai artwork lab)' 카테고리의 다른 글

| [튜토리얼]아.. 반 고흐가 내 초상화 그려줬으면 좋겠다 <dreambooth 깨부수기 -1-> (0) | 2023.07.12 |

|---|---|

| [튜토리얼]인공지능 생성 이미지는 손가락이 쫌.... 아닌데요!!??? <ControlNet 깨부수기 -2-> (0) | 2023.07.11 |

| [튜토리얼]최신유행 따라잡기! QR코드를 꾸며보자!!! <img2img, ControlNet> (0) | 2023.07.10 |

| [튜토리얼]초초강력 최신 기술을 당장 사용해보자!!!!! <SDXL 0.9> (0) | 2023.07.10 |

| [튜토리얼]이미지의 크기를 내멋대로 늘려보자! <Upscale -1-> + GAN 이해해보기~ (0) | 2023.07.07 |